Проект ЦОД для Билайн (Вымпелком) на базе ДДИБП Piller

«Билайну» нужно очень много вычислительной мощности для работы. Идея построить большой ЦОД и решить проблемы роста на 10 лет вперед витала с 2005 года. Я вкратце расскажу о том, с какими сложностями мы столкнулись, когда раздумывали о новом крупном объекте.

Сильнее, выше, быстрее, дешевле

Новый дата-центр

Первая проблема была в соотношении результатов и цен. Понятно, что строить ЦОД в Москве около уже имеющегося хочется, но не настолько сильно, чтобы тратить реально крупные суммы на строительство, и энергообеспечение. Поначалу мы отсмотрели около 30 объектов в Москве и области, но потом пришли к выводу, что экономически более обосновано строить где-то поблизости от столичного региона, но не непосредственно в нём.

Тут есть ещё сложность: между ЦОД в Москве и новым ЦОД не должно быть больше 200 километров оптоволокна, иначе скорость света уже существенно скажется на лагах при синхронной репликации. Параллельно мы купили новые модели дисковых массивов и получили возможность протестировать асинхронную репликацию. Так стало понятно, что географически разносить центры можно.

Выбираем место

Основной показатель любого ЦОД – это количество электроэнергии, которое он потребляет. Мы посчитали темпы роста за последние 10 лет, аппроксимировали этот рост, скорректировали его после кризиса 2008-го и выяснили, что нужно 10Мвт для решения вопроса на ближайшее будущее. Учитывая, что подключать мощность кусками не выгодно, требовалось сразу подвести именно такую линию к центру.

Следующий фактор выбора – температура региона и его влажность. Чем холоднее место в среднем – тем меньше нужно энергии на принудительное охлаждение, и тем экологичнее и экономичнее работа ЦОД. С влажностью ситуация такая: если воздух сухой, на платах начинают скапливаться статические разряды, а если слишком влажный, «выпадает роса». Оптимальным местом по результатам оценки стал Ярославль, который близок к Москве, технически-обеспечен, где можно взять много электроэнергии, есть дешевая земля и где подходящий температурный режим (90-95% времени мы не используем активное охлаждение, то есть работаем с внешним воздухом).

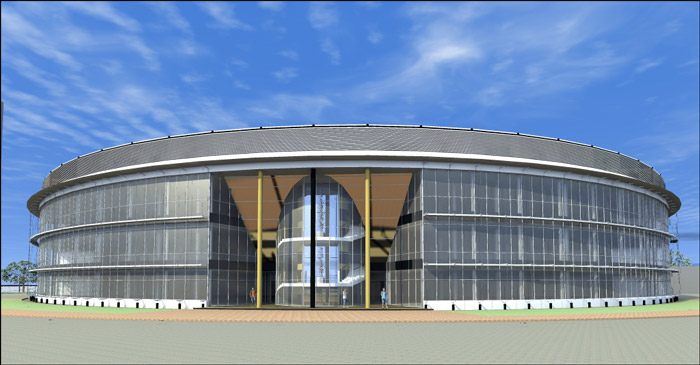

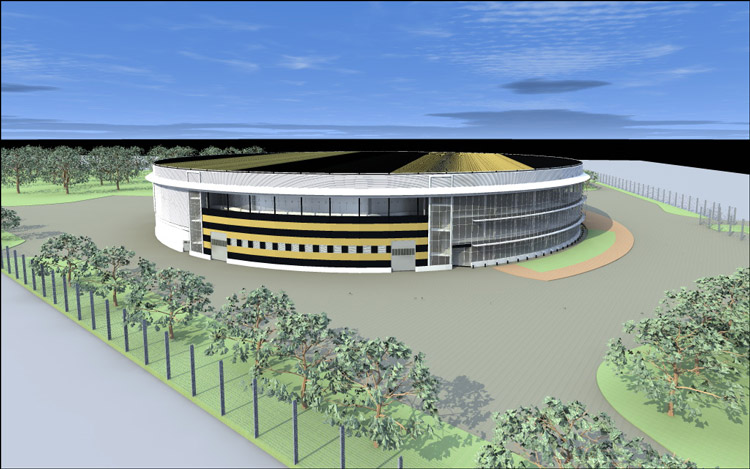

Здание ЦОД, вид сверху

Оцениваем стоимость конструкции

Модуль. Снаружи в реальности выглядит как большая серая коробка.

ЦОД сразу решили делать модульным. После конкурса среди 15 крупных компаний было выбрано решение на базе AST (Smart Shelter). Основной элемент конструкции – огнестойкие самонесущие панели, которые соединяются «ласточкиным хвостом» и закрываются профилями, защищающими как от температурных воздействий, так и от попыток несанкционированного проникновения. Конструкция модульного ЦОД представляет собой шесть автономных модулей, полезной площадью каждого 500 квадратных метров.

В самом ЦОД используется множество разных систем, которые позволят пережить любые бедствия: защита от повреждения водой и огнём, температурная защита, физическая защита, защита от самой жестокой непогоды, внутренних пожаров, проникновения, дурака, ЭМ-полей и так далее. Каждый модуль имеет свою децентрализованную инженерную инфраструктуру. При необходимости отдельные модули могут быть демонтированы и оперативно перевезены на новое место. Если в один из модулей попадает метеорит, это не сказывается на работе других модулей.

Модуль внутри, снято не в новом дата-центре.

Подбираем начинку

Учитывая, что для самого центра можно было использовать любые решения, благо ограничений не было, мы сосредоточились на том, что позволит обеспечить минимальное потребление ресурсов, то есть будет выгодным и экологичным. Вообще, быть экологичным современному дата-центру выгодно: это совпадает с основной парадигмой сокращения потребляемого питания и оптимального расходования ресурсов. По отчётам консалтинговых компаний, получалось около 40 различных решений для построения систем охлаждения и поддержания бесперебойного питания. Мы сразу отмели технологи не относящиеся к инженерным системам ЦОДа связанные с водяным охлаждением серверов, управлением питанием и охлаждением серверов на уровне ПО или BIOS, поскольку этим можно заниматься параллельно с принятием решений по выбору технологий. Экзотические системы охлаждения — такие как охлажденные балки, глубоководное охлаждение и другие, а также экзотические системы первичной или вторичной систем электропитания – ультраконденсаторы, геотермальные источники, солнечные батареи, приливно-отливные системы питания, ветряные мельницы тоже быстро «отвалились». Остальные системы при прямом анализе не вызвали отторжения и были подвергнуты дополнительному исследованию.

Первичный отбор

Сначала думали про колесо Киота. Однако учитывая требования Tier-3, нужно было делать ещё два таких же резервных узла, что потребовало бы очень много пространства. С интересом смотрели на интегрированные в сервера ИБП – данная технология выглядела многообещающей, поскольку не требовала централизованного ИБП. С другой стороны, разного железа много (дисковые массивы, ленточные библиотеки, сервера типа high-end), а унифицировать его быстро не выйдет, поэтому пришлось отказаться. Данная технология может применяться только в гомогенной среде с точки зрения серверов и накладывает большие ограничения на архитектуру ЦОДа в целом. Нашей задачей было строительство универсального дата-центра, где будет уживаться разношерстное оборудование, которое производилось 10 лет назад, производится сейчас и будет в следующие 10 лет. Потом мы стали смотреть на термальное хранилище – но тут был необходим большой объем, для 10 Мвт просто астрономический. Тригенерация на турбинах или топливных ячейках с использованием адсорбционных или абсорбционных систем хорошо смотрелась, пока мы не посчитали кейс на сравнении стоимости владения систем тригенерации и ДДИБП с модулями ЦОД и freecoling. У нас получилось что бизнес кейс становится положительным после 30 лет использования. Высокоэффективные статические UPS – такие системы уже используем, хорошо представляем себе сколько стоит внедрение подобного решения, а значит можем сравнить с новыми решениями.

Питание

Самой интересной технологией с точки зрения экономической обоснованности оказалось ДДИБП — дизель-динамический источник бесперебойного питания. Его основной принцип в том, что он накапливает кинетическую, а не химическую энергию, как обычные системы ИБП на батареях.

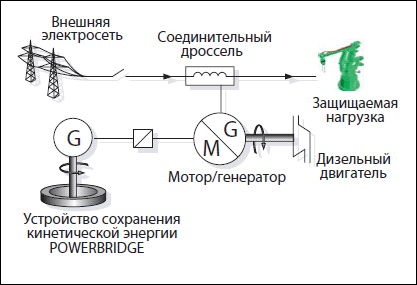

Схема питания

Он работает по тому же примерно принципу, что и классические системы бесперебойного питания – при кратковременных сбоях или некачественном питании (неправильная синусоида переменного напряжения, колебания частоты, амплитуды и т.д.) используется накопленная кинетическая энергия, при долговременных пропаданиях электроэнергии включается дизель-генератор. Благодаря «волчку» переключение питания происходит очень быстро и незаметно для потребителей, то есть без прыжков напряжения, например.

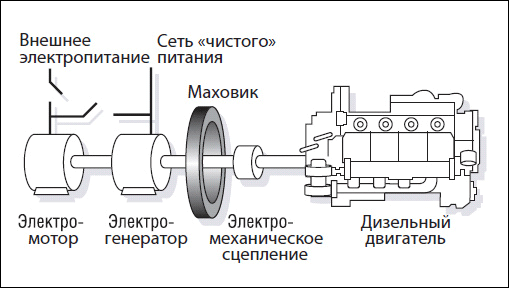

Устройство ИБП

Охлаждение

Для охлаждения была выбрана система естественного охлаждения окружающим воздухом “Natural Free Cooling” — это кондиционирование воздуха внутреннего пространства МЦОД основанная на принципе теплообмена между наружным воздухом и воздухом, циркулирующим в МЦОД, при этом обеспечивающая чистоту воздуха и контроль влажности. Система представляет собой два разомкнутых отдельных контура. Во внутреннем контуре циркулирует воздух ЦОД, в наружный контур подается внешний воздух. Основным элементом системы является рекуперативный теплообменник, в котором происходит теплообмен между наружным воздухом окружающей среды и воздухом в помещении МЦОД. Нагретый воздух удаляется из горячих зон вытяжными воздуховодами, охлажденный воздух подается в холодные коридоры. Использование адиабатического охлаждения (впыск воды в поток воздуха внешнего контура) позволяет увеличить диапазон температур работы системы охлаждения без подключения компрессорного контура холодоснабжения от +19 до +24 градусов Цельсия.

Территория. Деревья посажены так, чтобы не мешать ветру и охране.

Интересно, что при расчёте используемых технологий оказалось, что итоговая стоимость владения bleeding edge-технологическими решениями оказалась ниже при меньших сроках внедрения.

Основной параметр оценки эффективности ЦОД в этом плане — Power Usage Effectiveness, его физический смысл – это соотношение всей энергии потребляемой ЦОД к количеству энергии, потребляемой полезной нагрузкой. По нашим расчетам среднегодичный показатель PUE не будет превышать 1,3.